ROS2自动驾驶

yolo5自动驾驶

1、重要!更换U盘的操作指引

2、关闭开机自启动大程序

3、Linux基础

4、YoloV5训练集

5、自动驾驶基础调试(代码解析)

6、自动驾驶特调

7、自动驾驶原理

8、PID算法理论

9、阿克曼运动学分析理论

10、建立运动学模型

常用命令

!重要!首次使用

一、原理分析

麦克纳姆轮运动学分析

二、AI大模型

3、AI大模型类型和原理

4、RAG检索增强和模型训练样本

5、具身智能机器人系统架构

6、具身智能玩法核心源码解读

7、配置AI大模型

8、配置API-KEY

三、深度相机

2、颜色标定

10、深度相机的基础使用

11、深度相机伪彩色图像

12、深度相机测距

13、深度相机色块体积测算

14、深度相机颜色跟随

15、深度相机人脸跟随

16、深度相机KCF物体跟随

17、深度相机Mediapipe手势跟随

18、深度相机视觉循迹自动驾驶

19、深度相机边缘检测

四、多模态视觉理解

20、多模态语义理解、指令遵循

21、多模态视觉理解

22、多模态视觉理解+自动追踪

23、多模态视觉理解+视觉跟随

24、多模态视觉理解+视觉巡线

25、多模态视觉理解+深度相机距离问答

26、多模态视觉理解+SLAM导航

27、多模态视觉理解+SLAM导航+视觉巡线

28、意图揣测+多模态视觉理解+SLAM导航+视觉功能

五、雷达

8、雷达基础使用

思岚系列雷达

六、建立地图

9、Gmapping建图

cartographer快速重定位导航

RTAB-Map导航

RTAB-Map建图

slam-toolbox建图

cartographer建图

Navigation2多点导航避障

Navigation2单点导航避障

手机APP建图与导航

七、新机器人自动驾驶与调整

多模态视觉理解+SLAM导航

新机器人自动驾驶

场地摆放及注意事项

启动测试

识别调试

无人驾驶的车道保持

无人驾驶路标检测

无人驾驶红绿灯识别

无人驾驶之定点停车

无人驾驶转向决策

无人驾驶之喇叭鸣笛

无人驾驶减速慢行

无人驾驶限速行驶

无人驾驶自主泊车

无人驾驶综合应用

无人驾驶融合AI大模型应用

八、路网规划

路网规划导航简介

构建位姿地图

路网标注

路网规划结合沙盘地图案例

路径重规划

九、模型训练

1、数据采集

2、数据集标注

3、YOLOv11模型训练

4、模型格式转换

十、YOLOV11开发

多机通讯配置

汝城县职业中等专业学校知识库-信息中心朱老师编辑

-

+

首页

四、多模态视觉理解

27、多模态视觉理解+SLAM导航+视觉巡线

27、多模态视觉理解+SLAM导航+视觉巡线

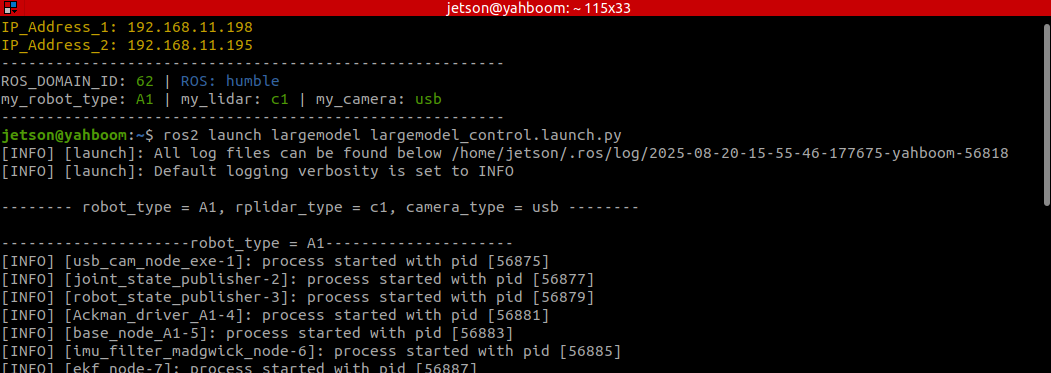

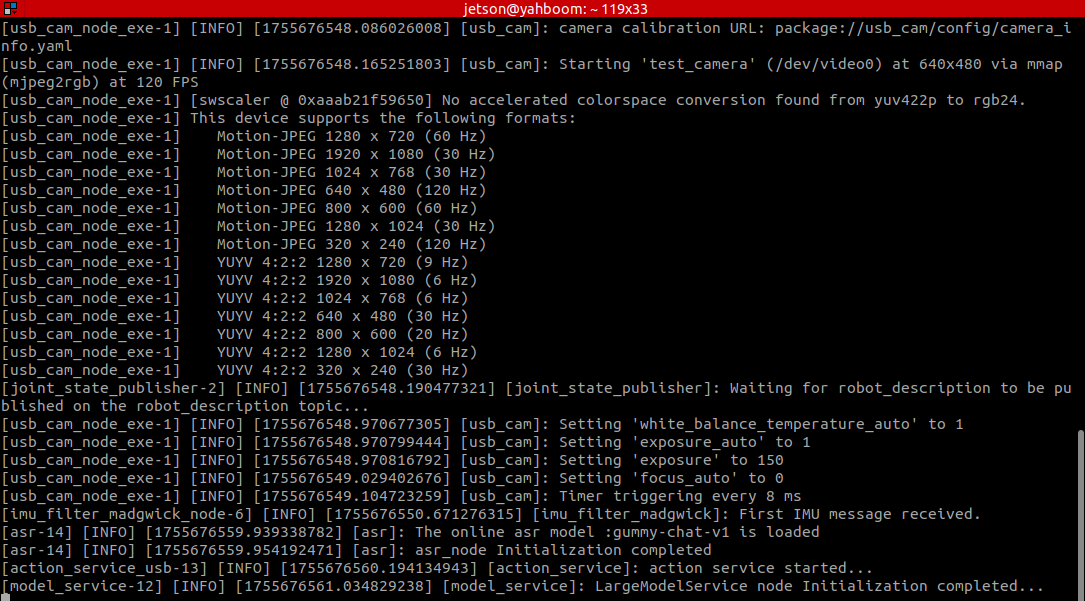

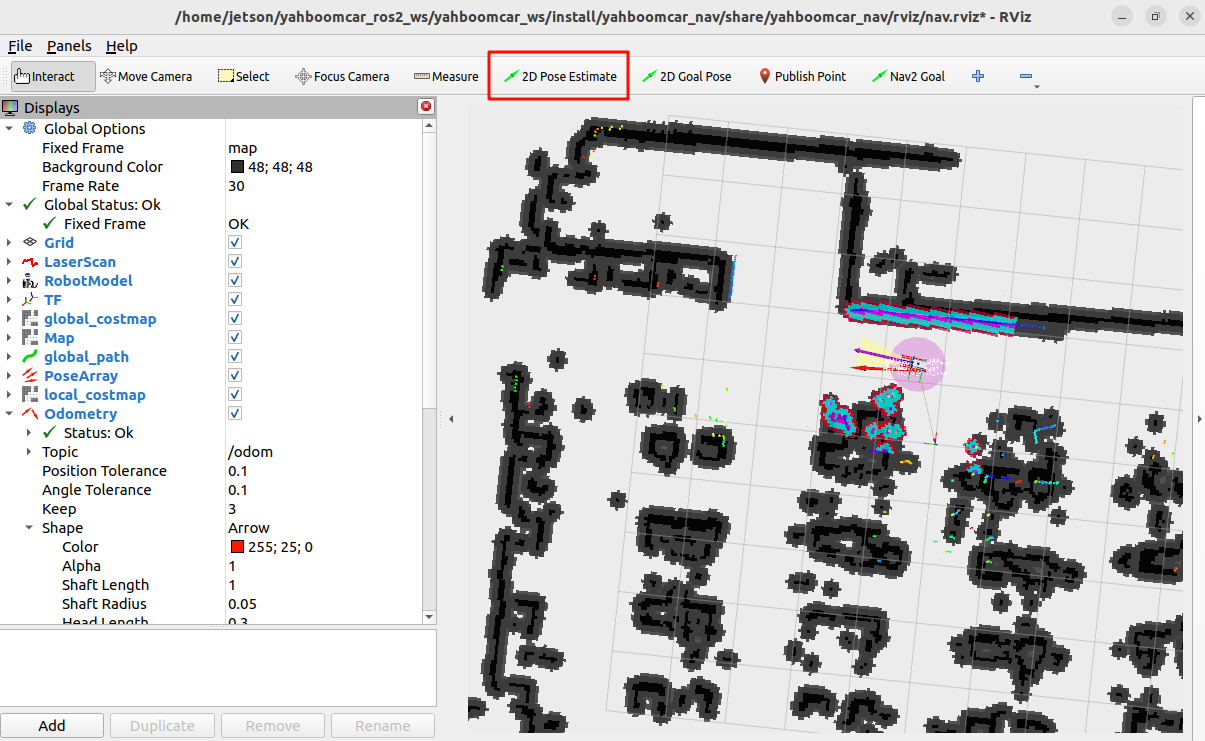

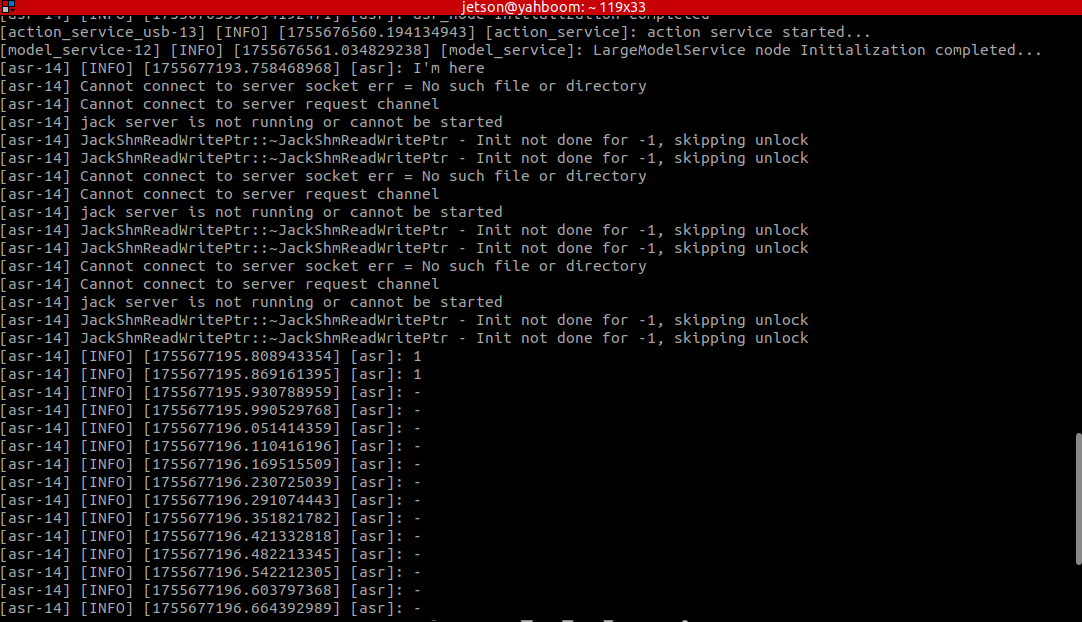

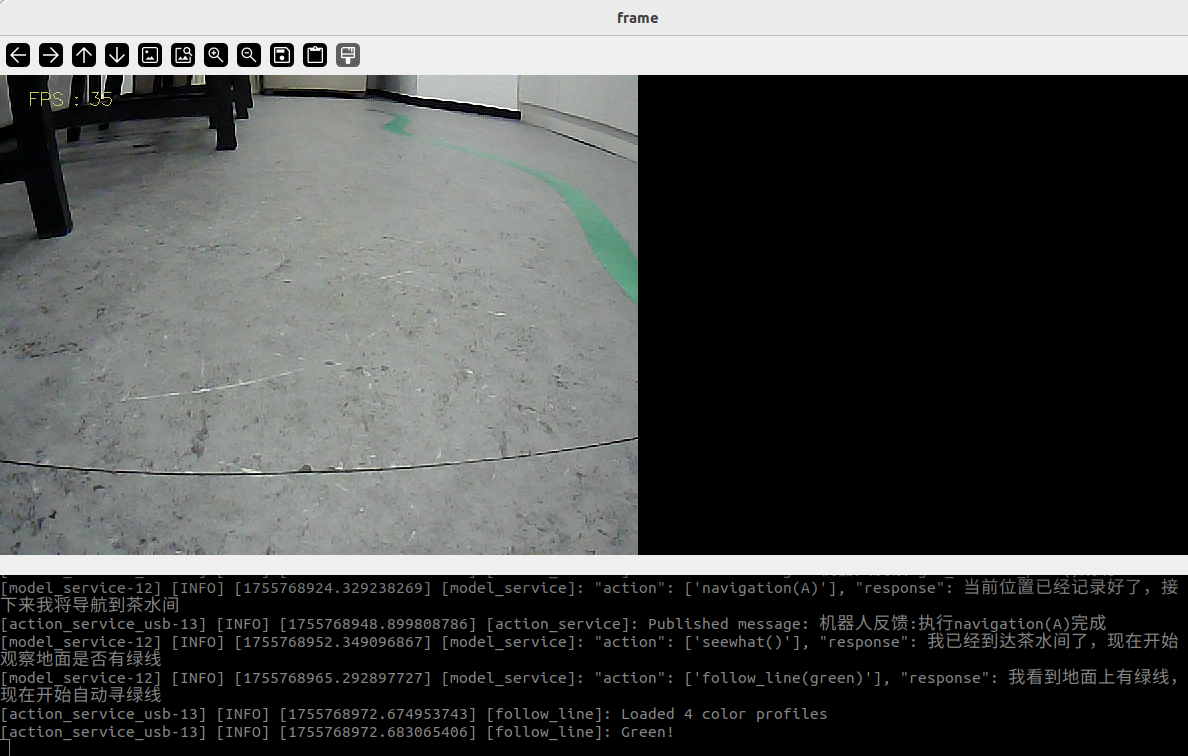

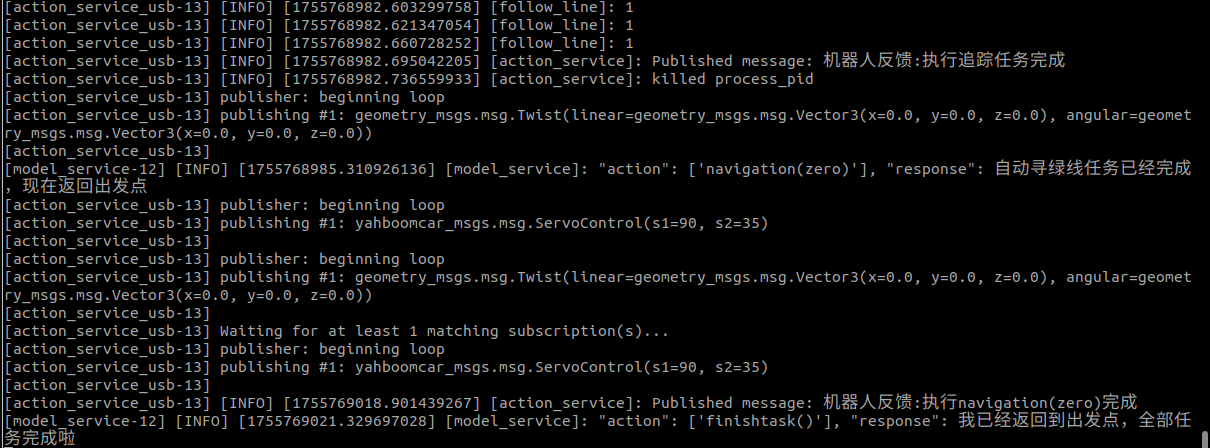

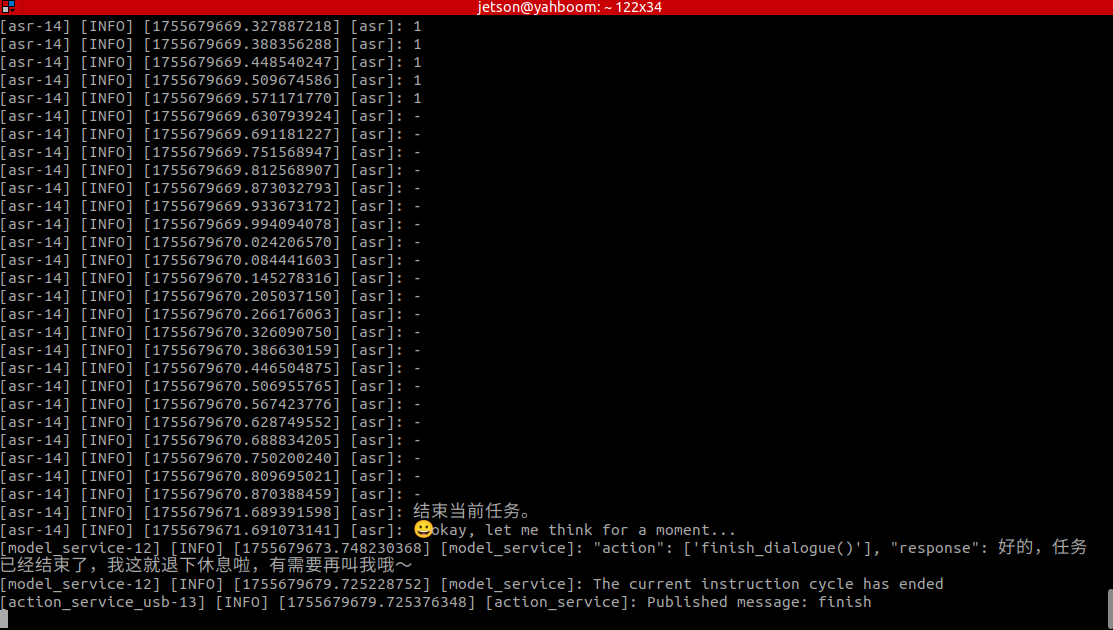

#### 1.课程内容 1.学习使用机器人的视觉理解、视觉巡线、SLAM导航、等复合功能案例 2.学习教程中新出现的关键源码 #### 3.注意:本章节课程需要先按照上一章节多模态视觉理解+SLAM导航完成地图映射文件的配置 #### 2.准备工作 **2.1 内容说明** 📝 示例使用multimodel : "qwen-vl-max-2025-04-08" 国际版用户使用model:"qwen/qwen2.5-vl-72b-instruct:free","qwen-vl-latest" ⚠️ 同样的测试指令,大模型回复的内容不会完全相同,和教程中截图会略有差异,如果需要增强或减弱大模型回复的多样性,参考【AI大模型基础知识】-【5.配置AI大模型】课程中配置决策层大模型参数部分。 ⚡️ 建议先体验前面的视觉案例,此案例是在单例的基础上增加了语音功能,功能上大部分一致,不再对程序的实现过程,代码调试,效果详细赘述!!! ### 3.运行案例 #### 3.1 启动程序 打开终端输入命令: ``` ros2 launch largemodel largemodel_control.launch.py ```  初始化完成后会显示如下内容  虚拟端新建一个终端启动 ``` ros2 launch yahboomcar_nav display_nav_launch.py ``` 等待导航算法开启即可出图,终端输入 ``` #导航算法二选一 #普通导航 ros2 launch yahboomcar_nav navigation_teb_launch.py #快速重定位导航 (RDKX5、树莓派5、jetsonnano主控不支持) ros2 launch yahboomcar_nav localization_imu_odom.launch.py use_rviz:=false load_state_filename:=/home/jetson/yahboomcar_ros2_ws/yahboomcar_ws/src/yahboomcar_nav/maps/yahboomcar.pbstream ros2 launch yahboomcar_nav navigation_cartodwb_launch.py maps:=/home/jetson/yahboomcar_ros2_ws/yahboomcar_ws/src/yahboomcar_nav/maps/yahboomcar.yaml params_file:=/home/jetson/yahboomcar_ros2_ws/yahboomcar_ws/src/yahboomcar_nav/params/cartoteb_nav_params.yaml ``` **注:此处yahboomcar.yaml必须和yahboomcar.pbstream是同时完成建图的,即是同一个地图,参考cartograph建图算法保存地图** 之后按照启动导航功能的流程进行初始化定位,会打开rviz2的可视化界面,点击上方工具栏中的**2D Pose Estimate**,进入选择状态,在地图上大致标出具机器人所在的位置和朝向,初始化定位之后,准备工作完成  3.2 测试案例 这里给出参考的测试案例,用户可自行编撰自己的对话指令 前进0.5米后退0.5米,记录当前位置,导航到茶水间观察地面有没有绿线,有绿线的话进行自动巡绿线,巡绿线结束之后,返回到出发点 ### 3.2.1 案例 首先使用"你好小亚"唤醒机器人,机器人回应:"我在,请吩咐",机器人应答后蜂鸣器短暂(beep—)响后,用户可以进行讲话,机器人会进行动态声音检测,如果有声音活动则打印1,无声音活动会打印-,当说话结束后会进行尾音检测,静音超过450ms则停止录音。 动态声音检测(VAD)如下图所示:  机器人会先与用户进行对方回复用户,然后按照指令动作,同时终端打印信息如下: **网络异常情况:决策层AI规划:The model service is abnormal. Check the large model account or configuration options,不影响AI模型决策功能,但是建议在网络流畅条件再尝试!!** 正常情况:决策层AI规划会分出1.2.3.4等等步骤  [model_service]: "action": ['seewhat()'], "response": 我已经到达茶水间了,现在观察地面是否有绿线 到达导航目的地后,这个步骤调用seewhat方法,VNC画面中会打开窗口显示5s,获取一张图片上传到大模型推理  大模型得到结果,反馈观察到了绿线,所以开始运行自动巡绿线程序  逻辑和前面的案例一样,如果画面中没有需要追踪的目标,程序会计时10s,终端打印5秒倒数,进程自动结束,视为任务已经完成, 并进行接下来的指令,返回到出发点  完成所有任务,此时机器人又再次进入自由对话状态,但所有的对话历史会被一直保留。此时可以再此唤醒小亚,“结束当前任务”,让机器人结束当前的任务周期,清理掉对话历史,开启新的任务周期。

admin

2025年12月6日 22:22

23

转发

收藏文档

上一篇

下一篇

手机扫码

复制链接

手机扫一扫转发分享

复制链接

Markdown文件

Word文件

PDF文档

PDF文档(打印)

分享

链接

类型

密码

更新密码

有效期

AI