ROS2自动驾驶

yolo5自动驾驶

1、重要!更换U盘的操作指引

2、关闭开机自启动大程序

3、Linux基础

4、YoloV5训练集

5、自动驾驶基础调试(代码解析)

6、自动驾驶特调

7、自动驾驶原理

8、PID算法理论

9、阿克曼运动学分析理论

10、建立运动学模型

常用命令

!重要!首次使用

一、原理分析

麦克纳姆轮运动学分析

二、AI大模型

3、AI大模型类型和原理

4、RAG检索增强和模型训练样本

5、具身智能机器人系统架构

6、具身智能玩法核心源码解读

7、配置AI大模型

8、配置API-KEY

三、深度相机

2、颜色标定

10、深度相机的基础使用

11、深度相机伪彩色图像

12、深度相机测距

13、深度相机色块体积测算

14、深度相机颜色跟随

15、深度相机人脸跟随

16、深度相机KCF物体跟随

17、深度相机Mediapipe手势跟随

18、深度相机视觉循迹自动驾驶

19、深度相机边缘检测

四、多模态视觉理解

20、多模态语义理解、指令遵循

21、多模态视觉理解

22、多模态视觉理解+自动追踪

23、多模态视觉理解+视觉跟随

24、多模态视觉理解+视觉巡线

25、多模态视觉理解+深度相机距离问答

26、多模态视觉理解+SLAM导航

27、多模态视觉理解+SLAM导航+视觉巡线

28、意图揣测+多模态视觉理解+SLAM导航+视觉功能

五、雷达

8、雷达基础使用

思岚系列雷达

六、建立地图

9、Gmapping建图

cartographer快速重定位导航

RTAB-Map导航

RTAB-Map建图

slam-toolbox建图

cartographer建图

Navigation2多点导航避障

Navigation2单点导航避障

手机APP建图与导航

七、新机器人自动驾驶与调整

多模态视觉理解+SLAM导航

新机器人自动驾驶

场地摆放及注意事项

启动测试

识别调试

无人驾驶的车道保持

无人驾驶路标检测

无人驾驶红绿灯识别

无人驾驶之定点停车

无人驾驶转向决策

无人驾驶之喇叭鸣笛

无人驾驶减速慢行

无人驾驶限速行驶

无人驾驶自主泊车

无人驾驶综合应用

无人驾驶融合AI大模型应用

八、路网规划

路网规划导航简介

构建位姿地图

路网标注

路网规划结合沙盘地图案例

路径重规划

九、模型训练

1、数据采集

2、数据集标注

3、YOLOv11模型训练

4、模型格式转换

十、YOLOV11开发

多机通讯配置

汝城县职业中等专业学校知识库-信息中心朱老师编辑

-

+

首页

四、多模态视觉理解

20、多模态语义理解、指令遵循

20、多模态语义理解、指令遵循

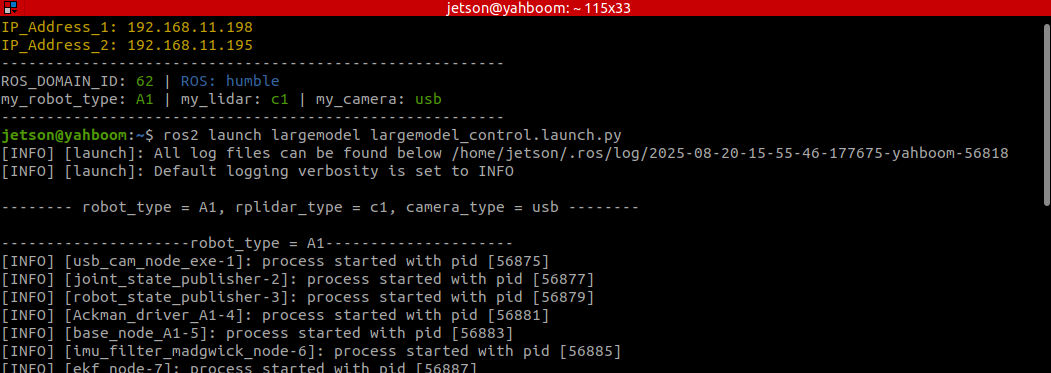

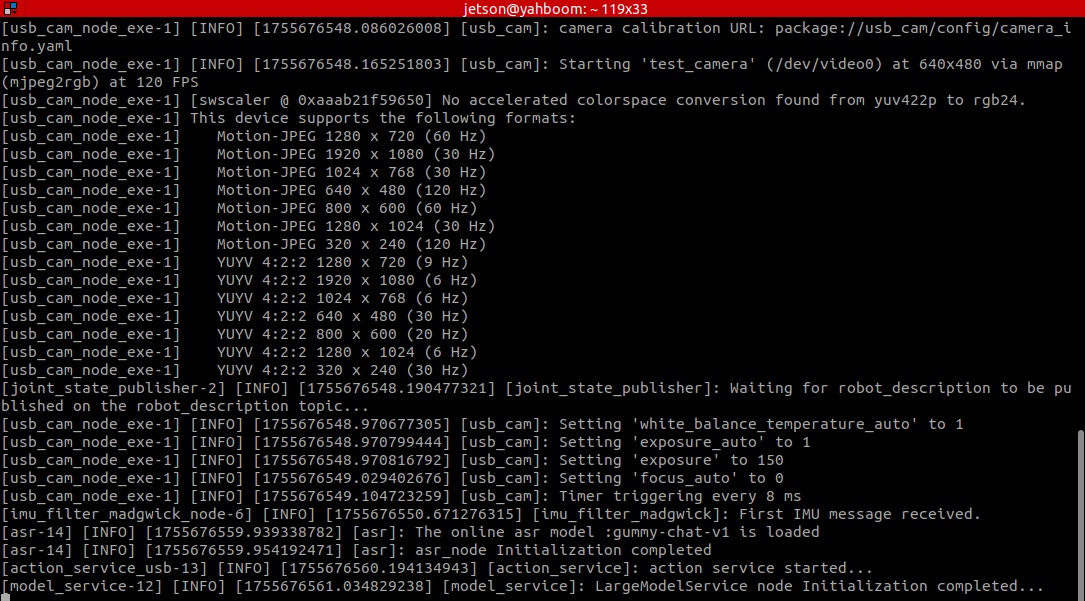

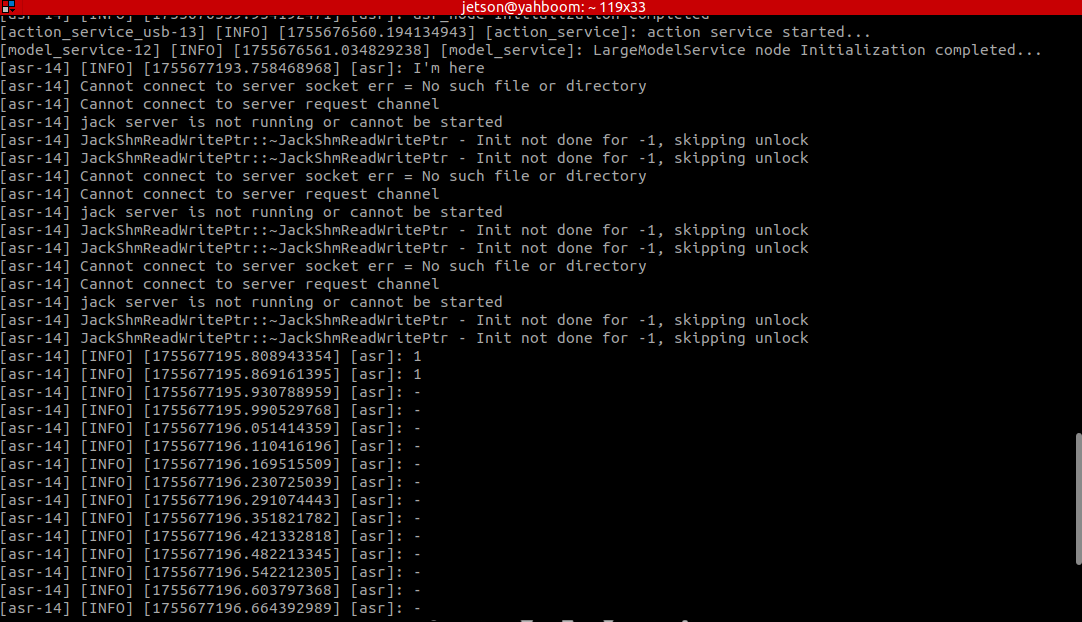

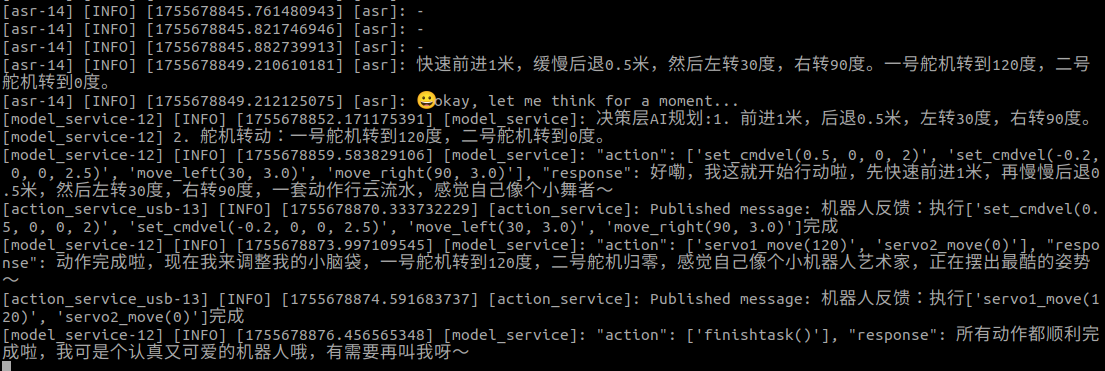

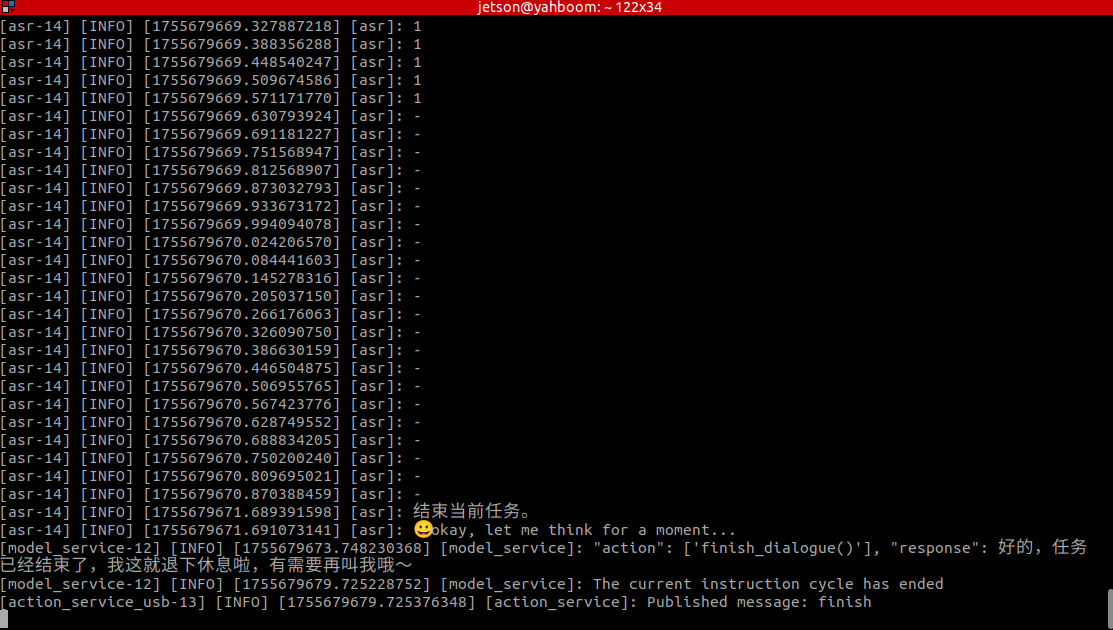

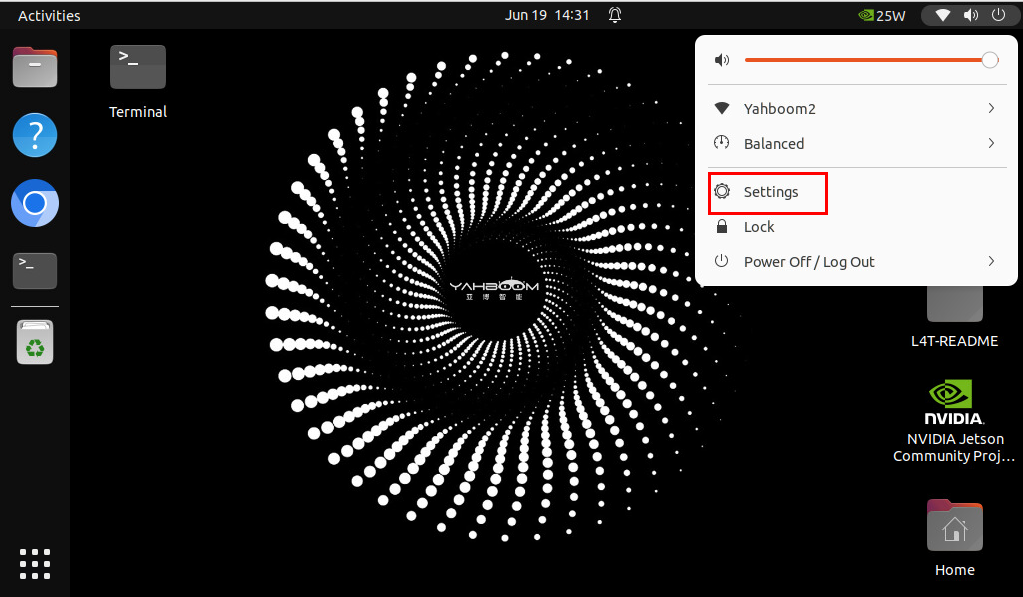

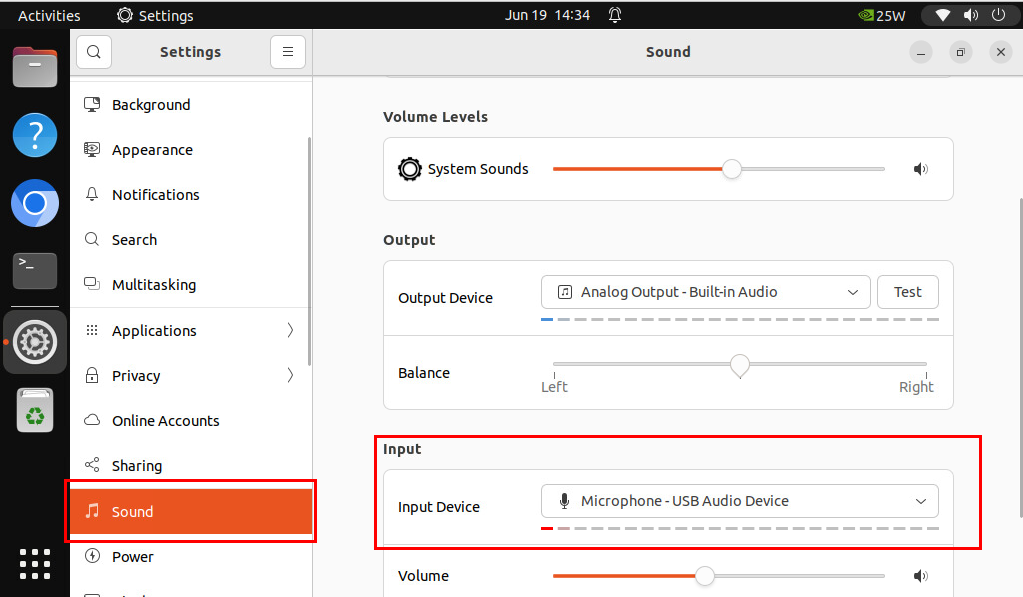

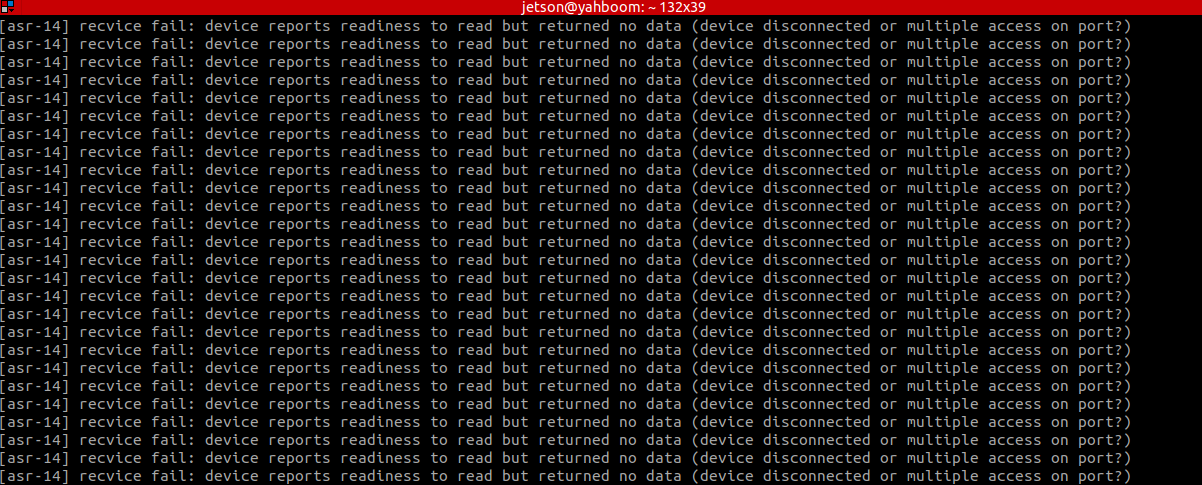

### **多模态是指利用多种不同形式或感知渠道的信息进行表达、交流和理解的方式,通常包括视觉、听觉、文本、触觉等多种感官输入和输出方式。在计算机科学、人工智能和机器学习领域,多模态技术指的是通过整合来自不同模态的数据(如图像、文字、音频、视频等),从而增强模型的理解能力和推理能力。这种整合可以提高信息的完整性和准确性,因为每种模态可以为特定任务提供独特的信息。例如,在自动驾驶中,摄像头提供视觉信息,激光雷达提供空间感知数据,结合这些多模态信息可以使系统更好地识别障碍物并做出准确的决策。在自然语言处理和计算机视觉领域,多模态模型能够同时处理图像和文本任务,如图文描述生成、视觉问答等,帮助模型实现跨领域的理解和生成。这种多模态技术被广泛应用于人机交互、自动驾驶、医疗诊断等场景,展示了其强大的应用潜力。** ### 1、语义理解和指令遵循 #### 1.课程内容 运行大模型程序后,用户可以通过语音对话方式与机器人进行交互,用户语音指令首先通过语音识别大模型转换成文字,再由文本生成大模型和视觉多模态精准理解用户指令和语音,最后机器人按照用户指令完成指定动作并回复用户。 ### 2.准备工作 连接机器人,打开终端 ### 3. 运行案例 #### 3.1 启动程序 打开终端输入命令: ``` ros2 launch largemodel largemodel_control.launch.py ```  初始化完成后会显示如下内容  ### 3.2 测试案例 这里给出的测试案例,可以自行编撰自己的测试指令 比如: **快速前进1米,缓慢后退0.5米,然后左转30度,右转90度,1号舵机转到120度,2号舵机转到0度。 将舵机复位后,顺时针转一圈,然后再给我讲个关于小猫和小狗的笑话** #### 3.2.1 案例1 首先使用"你好小亚"唤醒机器人,机器人回应:"**我在,请吩咐**",机器人应答后蜂鸣器短暂(beep—)响后,用户可以进行讲话,机器人会进行动态声音检测,如果有声音活动则打印1,无声音活动会打印-,当说话结束后会进行尾音检测,静音超过450ms则停止录音。 动态声音检测(VAD)如下图所示:  机器人会先与用户进行对方回复用户,然后按照指令动作,同时终端打印信息如下:  **大模型回复信息解读:** **决策层大模型输出**:决策层AI规划:1. 前进1米, 后退0.5米, 左转30度, 右转90度 2.一号舵机转到120度, 二号舵机转到0度。 **决策层大模型输出**:[model_service]: "action": ['set_cmdvel(0.5, 0, 0, 2)', 'set_cmdvel(-0.2, 0, 0, 2.5)', 'move_left(30, 3.0)', 'move_right(90, 3.0)'], "response": 好嘞,我这就开始行动啦,先快速前进1米,再慢慢后退0.5米,然后左转30度,右转90度,一套动作行云流水,感觉自己像个小舞者~、[action_service]: Published message: 机器人反馈:执行['set_cmdvel(0.5, 0, 0, 2)', 'set_cmdvel(-0.2, 0, 0, 2.5)', 'move_left(30, 3.0)', 'move_right(90, 3.0)']完成,[model_service]: "action": ['servo1_move(120)', 'servo2_move(0)'], "response":动作完成啦,现在我来调整我的小脑袋,一号舵机转到120度,二号舵机归零,感觉自己像个小机器人艺术家,正在摆出最酷的姿势~,[action_service]: Published message: 机器人反馈:执行['servo1_move(120)', 'servo2_move(0)']完成、[model_service]: action": ['finishtask()'], "response": 所有动作都顺利完成啦,我可是个认真又可爱的机器人哦,有需要再叫我呀~ 动作列表中有**finishtask()**,证明执行层大模型判定机器人已经完成了用户指令,进入**等待状态**,此时可以再此唤醒小亚,结束当前任务:  **3.2.2 案例2** 和案例1测试相同,首先使用"你好小亚"唤醒机器人,机器人应答后蜂鸣器短暂(beep—)响后,用户可以进行讲话,讲话完成后,机器人回复用户并按照指令进行运动。  ### 4.常见问题解决方案 #### 4.1麦克风录音过于灵敏 如果发现在说话阶段结束后VAD语音活动检测一直显示“1”,无法停止录音证明是麦克风设置过于灵敏一直有语音活动,可以尝试降低麦克风灵敏度 首先通过VNC连接机器人车机端画面,jetson用户,点击右上方选项栏,找到**Settings**选项。  下拉左侧Settings列表,找大Sound选项,在Sound页面找到Input音频输入Input Device,拖动下方Volume即可调整灵敏度,录音时尝试调整至合适值。  ### 5.2麦克风录音不灵敏 如果说话人的位置与机器人之间距离较远,则VAD语音活动检测可能会检测不到声音活动,导致说话人话没说完就提前结束录音,此时可以参考5.1麦克风录音过于灵敏中的步骤适当增大麦克风灵敏度。 >i **信息提示** > > 注意: > 如果麦克风灵敏度调整的过高,则可能提高对环境噪音的误判,将环境噪音认为是语音活动。 ### 5.3语音识别不完整 不同语音识别模型对相同音频的识别效果会有差异,推荐使用默认设置的paraformer系列模型或本地SenseVoiceSmall 模型。我们机器人默认就是这个。 #### 5.4语音模块识别错误 语音模块接触不稳定,建议更换USB口,或者拔插解决

admin

2025年12月1日 19:04

25

转发

收藏文档

上一篇

下一篇

手机扫码

复制链接

手机扫一扫转发分享

复制链接

Markdown文件

Word文件

PDF文档

PDF文档(打印)

分享

链接

类型

密码

更新密码

有效期

AI