ROS2自动驾驶

yolo5自动驾驶

1、重要!更换U盘的操作指引

2、关闭开机自启动大程序

3、Linux基础

4、YoloV5训练集

5、自动驾驶基础调试(代码解析)

6、自动驾驶特调

7、自动驾驶原理

8、PID算法理论

9、阿克曼运动学分析理论

10、建立运动学模型

常用命令

!重要!首次使用

一、原理分析

麦克纳姆轮运动学分析

二、AI大模型

3、AI大模型类型和原理

4、RAG检索增强和模型训练样本

5、具身智能机器人系统架构

6、具身智能玩法核心源码解读

7、配置AI大模型

8、配置API-KEY

三、深度相机

2、颜色标定

10、深度相机的基础使用

11、深度相机伪彩色图像

12、深度相机测距

13、深度相机色块体积测算

14、深度相机颜色跟随

15、深度相机人脸跟随

16、深度相机KCF物体跟随

17、深度相机Mediapipe手势跟随

18、深度相机视觉循迹自动驾驶

19、深度相机边缘检测

四、多模态视觉理解

20、多模态语义理解、指令遵循

21、多模态视觉理解

22、多模态视觉理解+自动追踪

23、多模态视觉理解+视觉跟随

24、多模态视觉理解+视觉巡线

25、多模态视觉理解+深度相机距离问答

26、多模态视觉理解+SLAM导航

27、多模态视觉理解+SLAM导航+视觉巡线

28、意图揣测+多模态视觉理解+SLAM导航+视觉功能

五、雷达

8、雷达基础使用

思岚系列雷达

六、建立地图

9、Gmapping建图

cartographer快速重定位导航

RTAB-Map导航

RTAB-Map建图

slam-toolbox建图

cartographer建图

Navigation2多点导航避障

Navigation2单点导航避障

手机APP建图与导航

七、新机器人自动驾驶与调整

多模态视觉理解+SLAM导航

新机器人自动驾驶

场地摆放及注意事项

启动测试

识别调试

无人驾驶的车道保持

无人驾驶路标检测

无人驾驶红绿灯识别

无人驾驶之定点停车

无人驾驶转向决策

无人驾驶之喇叭鸣笛

无人驾驶减速慢行

无人驾驶限速行驶

无人驾驶自主泊车

无人驾驶综合应用

无人驾驶融合AI大模型应用

八、路网规划

路网规划导航简介

构建位姿地图

路网标注

路网规划结合沙盘地图案例

路径重规划

九、模型训练

1、数据采集

2、数据集标注

3、YOLOv11模型训练

4、模型格式转换

十、YOLOV11开发

多机通讯配置

汝城县职业中等专业学校知识库-信息中心朱老师编辑

-

+

首页

九、模型训练

3、YOLOv11模型训练

3、YOLOv11模型训练

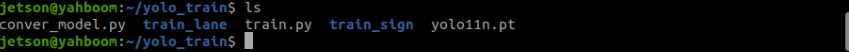

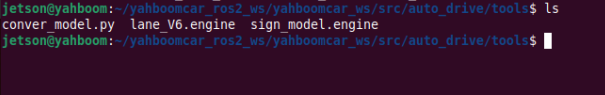

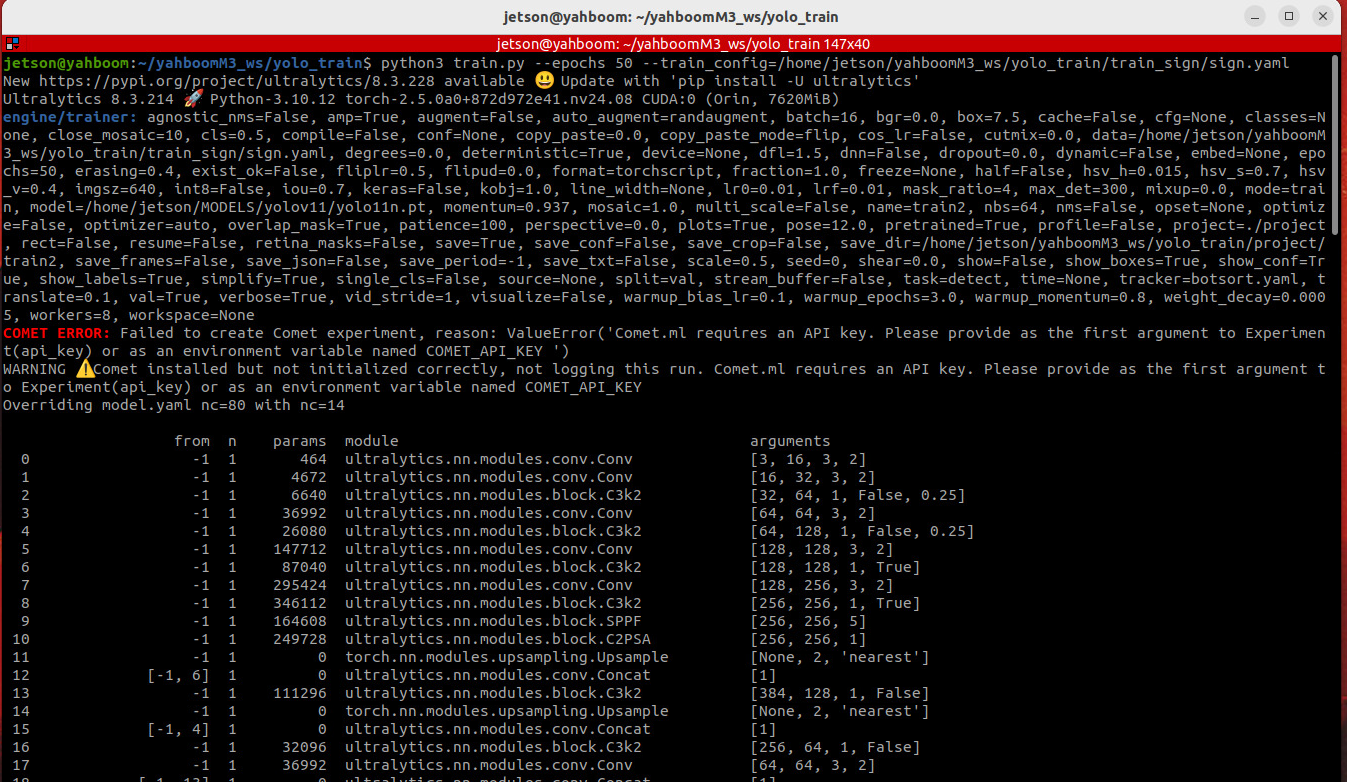

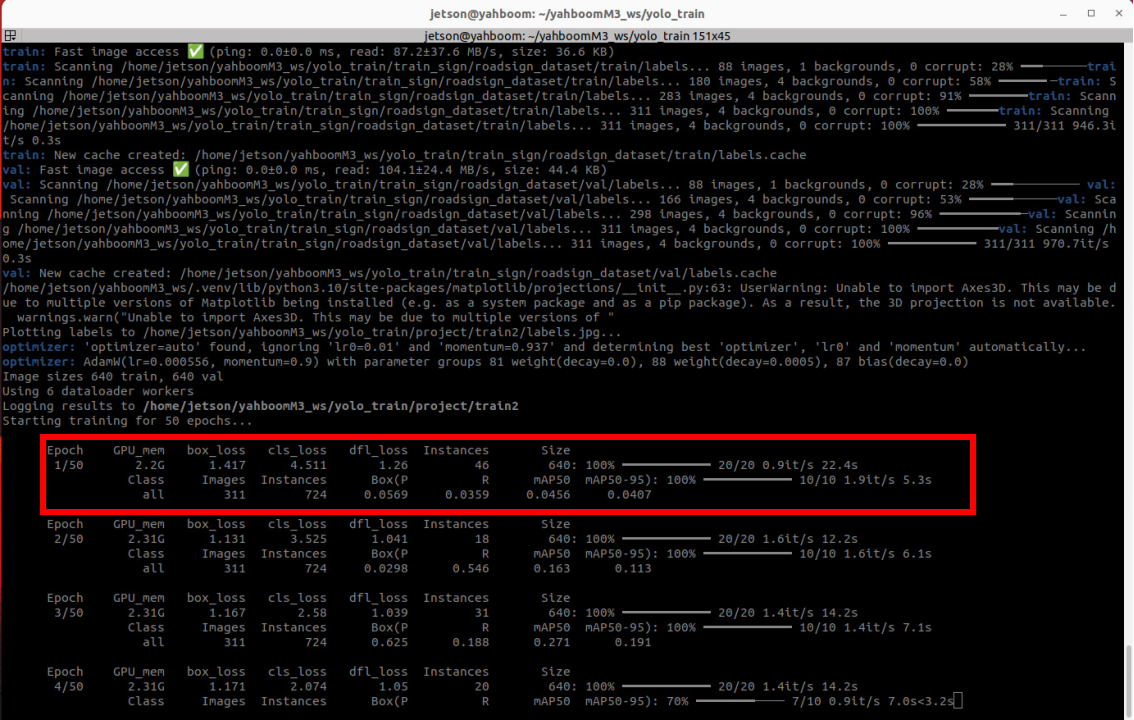

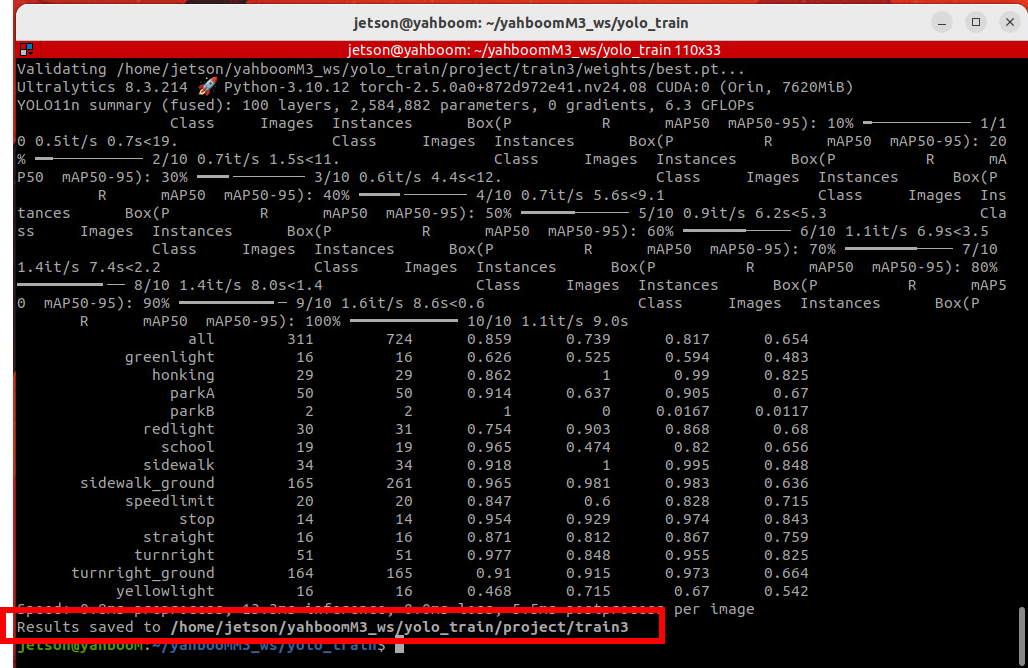

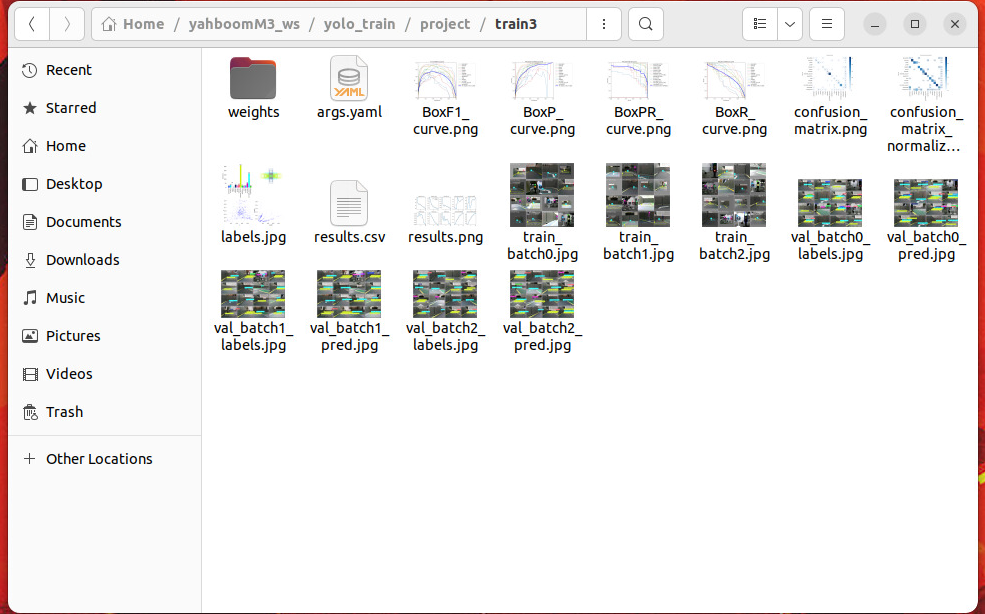

# YOLOv11模型训练 >i **信息提示** > > * 机器人镜像已经包含了预训练的交通标志识别模型,本>节教程提供给有需要自行训练yolov11目标检测模型和掌握模>型训练方法的用户。 > 如果需要直接体验完整功能,可略过本节课程!!! > 如果使用出厂镜像中的数据集训练模型,需要先解压.zip格式的数据集压缩包。 > 本教程主要是在orin nano主板上面进行 ## 1. 课程内容 1. 掌握训练YOLOv11训练目标检测模型的方法 ## 2. 预训练模型 * **只有orin主板才建议在主板上进行模型训练,RDK主板因为性能不足需要在自己带GPU的主机进行标注和训练,训练源码在源码汇总的模型训练下的yolo_train文件夹,需要训练的可以自行将yolo_train文件夹程序放到主板根目录下** * yolo11n.pt基模型 /home/jetson/yolo_train/yolo11n.pt  * 车道线检测模型路径: /home/jetson/yahboomcar_ros2_ws/yahboomcar_ws/src/auto_drive/tools/lane_V6.engine * 交通标识识别模型路径: /home/jetson/yahboomcar_ros2_ws/yahboomcar_ws/src/auto_drive/tools/sign_model.engine  ## 3. 训练交通标识识别模型(案例1) yolov11训练目标检测模型的程序路径:`/home/jetson/yolo_train/train.py` 可选启动参数说明: * **project**: 训练输出文件夹,默认为`./project` * **MODEL_PATH**:yolov11基模型路径,默认为`/home/jetson/MODELS/yolov11/yolo11n.pt` * **epochs**:训练轮次,轮次越多识别模型效果越好,默认为100轮 * **imgsz**:训练图像尺寸,默认为640 * **train_config**:配置文件路径,用于描述数据集路径和目标类别 ### 3.1开始训练 * 这里以训练50轮次为例(建议训练轮次在100轮以上): cd ~/yolo_train python3 train.py --epochs 50 --train_config=/home/jetson/yolo_train/train_sign/sign.yaml  * 训练过程中会显示每个轮次的训练时长和损失值  * **Epoch** 当前训练轮次 * **GPU_mem** 当前训练占用的 GPU 内存 * **box_loss** 边界框回归损失值,衡量预测框与真实框(位置、大小)的差异,值越小说明框定位越准 * **cls_loss** 分类损失值,衡量预测类别与真实类别的差异,值越小说明分类越准。 * **dfl_loss** 分布焦点损失,用于优化边界框的回归精度,尤其针对小目标,值越小说明边界框细节预测越准。 * **Instances 46**:当前批次(batch)中包含的目标实例总数。 * **Size 640**:输入图像的尺寸为 640x640(YOLOv11 默认的训练输入尺寸)。 * 训练完成后终端会提示训练输出文件的保存路径  * 在输出文件夹中我们可以看到如下内容 * **weights**训练的模型权重文件 * **.png** 训练过程中的得分数据  ## 4. 训练车道线检测模型(案例2) * 训练方法和前边相同 cd ~/yolo_train * 开始训练 python3 train.py --epochs 50 --train_config=/home/jetson/yolo_train/train_lane/lane.yaml --project './project2' 这里`--project`参数是指定训练输出文件的文件夹,用于和前边的交通标识识别模型区分,这里路径设置为`'./project2'`,训练完成后模型权重文件会保存在project参数指定的路径中 ## 5.源码解析 ### 5.1 YOLOv11训练程序 程序源码位于`/home/jetson/yolo_train/train.py` * 通过`argparse`库定义了训练过程中需要的配置参数,允许在运行脚本时通过命令行传入参数 * 训练过程中,会自动生成日志、损失曲线、评估指标(如 mAP)、模型权重文件(best.pt、last.pt 等),并保存在`--project`指定的目录中。 ``` import argparse from ultralytics import YOLO def get_args(): ''' ''' parser = argparse.ArgumentParser() parser.add_argument('--project', default='./project', help='Project file output directory', type=str) parser.add_argument('--MODEL_PATH',default='/home/jetson/MODELS/yolov11/yolo11n.pt' ,help='原始模型权重文件路径Original model weight file path', type=str) parser.add_argument('--epochs', default=100, help='训练轮次Training rounds', type=int) parser.add_argument('--imgsz', default=640, help='图像大小Image size', type=int) parser.add_argument('--train_config', default='', help='配置文件路径Configuration file path', type=str) return parser.parse_args() if __name__ == "__main__": args = get_args() model = YOLO(args.MODEL_PATH) # 加载预训练模型 load a pretrained model results = model.train(data=args.train_config, epochs=args.epochs, imgsz=args.imgsz,project=args.project)#开始训练 start training ```

admin

2025年12月28日 18:20

16

转发

收藏文档

上一篇

下一篇

手机扫码

复制链接

手机扫一扫转发分享

复制链接

Markdown文件

Word文件

PDF文档

PDF文档(打印)

分享

链接

类型

密码

更新密码

有效期

AI